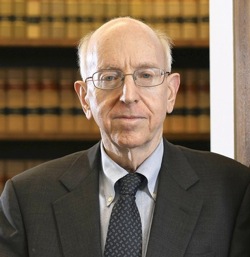

Richard Posner.是法学家,法律理论家和经济学家。他也是近40本书的作者,并且到目前为止20世纪最多的法律学者。

Richard Posner.是法学家,法律理论家和经济学家。他也是近40本书的作者,并且到目前为止20世纪最多的法律学者。

2004年,Posner发表了灾难:风险和反应,他讨论了风险agi.一定长度。他的分析部分是有趣的,因为它似乎是智力上独立于今天主导主题的波斯特罗姆 - Yudkowsky传统。

事实上,Posner没有出现请注意,我通过i.j的早期工作。好的 (1970年那1982年),Ed Fredkin(1979年),Roger Clarke(1993年那1994年),Daniel Weld&Oren Etzioni(1994年),James GIPS(1995年),Broad Whitby(1996年),戴安娜戈登(2000年),克里斯哈珀(2000年)或Colin Allen(2000年)。他甚至没有意识到HANS MORAVEC(1990年那1999年),比尔乔斯(2000年),尼克斯特罗姆(1997.;2003年)或Eliezer Yudkowsky(2001年)。基本上,他似乎只知道Ray Kurzweil(1999年)。

尽管如此,Posner的分析仍然与Bostrom-yudkowsky传统的基本要点一致:

[一类灾难性风险]包括......科学事故,例如涉及粒子加速器,纳米技术......和人工智能的事故。技术是这些风险的原因,减缓技术可能是正确的反应。

......可能有一天,也许有一天好(几十年,而不是几个世纪,因此),是人类的机器人,[此后很快]比人类智慧更多......

......人类可能会成为二十一世纪的黑猩猩,如果是,那么机器人可能会像我们为我们的研究员那样少使用并尊重我们,但是诺布努姆,灵长类......

......机器人的潜在破坏性并不依赖于它的意识或能够参与[例如情绪处理] ...除非仔细编程,机器人可能会难以破坏性地破坏并打开他们的创造者。

...... Kurzweil可能是正确的,“一旦计算机实现了人类的智力,它必须咆哮”......

一个主要分歧的重点似乎是Posner关于AGIS成为自我意识,重新评估目标的情景的担忧,并决定不再被笨拙的物种“。相比之下,波斯纹和yudkowsky认为AGIS将危险不会是危险的,因为他们将“反叛”对抗人类,而是因为(粗略地)使用所有可用的资源 - 包括人类生活所取决于的那些 - 是几乎任何决赛的收敛工具目标目标强大的AGI可能拥有。(见e.Bostrom 2012.。)

你喜欢这篇文章吗?你可以享受我们的其他yabo app 帖子,包括: